Zunächst sollten Sie sich noch einmal klar machen, wie sich Closed Innovation und Open Innovation unterscheiden. Wie so oft, gibt es nicht nur die beiden Pole, sondern ein Innovations-Kontinuum (Roth 2008). Weiterhin finden Sie in dem Beitrag Künstliche Intelligenz im Innovationsprozess von Organisationen Hinweise dazu, welche Vorteile, bzw. Nachteile es geben kann, wenn für jeden Schritt im Innovationsprozess eines der bekannten KI-Modelle wie ChatGPT, Gemeni etc. genutzt wird.

In diesem Beitrag geht es mir darum aufzuzeigen, wie Künstliche Intelligenz bei Open Innovation genutzt werden kann. Wie der folgenden Tabelle zu entnehmen ist, kann zwischen der Verbesserung von Open Innovation durch KI (OI-Enhancing AI), einer Ermöglichung von Open Innovation durch KI (OI-Enabling AI) und der Ersetzung von Open Innovation durch KI (OI-Peplacing AI) unterschiedenen werden. Die jeweils genannten Beispiele zeigen konkrete Einsatzfelder.

| Description | Examples | |

| OI-Enhancing AI | AI that enhances established forms of open innovation by utilizing the advantages of AI complemented with human involvement | Innovation search Partner search Idea evaluation Resource utilization |

| OI-Enabling AI | AI that enables new forms of open innovation, based upon AI’s potential to coordinate and/or generate innovation | AI-enabled markets AI-enabled open business models Federated learning |

| OI-Replacing AI | AI that replaces or significantly reshapes established forms of open innovation | AI ideation Synthetic data Multi-agent systems |

Alle drei Möglichkeiten – mit den jeweils genannten Beispielen – können von einem KI-Modell (z.B. ChatGPT oder Gemeni etc.) der eher kommerziell orientierten Anbieter abgedeckt werden. Dieses Vorgehen kann als One Sizes Fits All bezeichnet werden.

Eine andere Vorgehensweise wäre, verschiedene spezialisierte Trainingsmodelle (Large Language Models) für die einzelnen Prozessschritte einzusetzen. Ein wesentlicher Vorteil wäre, dass solche LLM viel kleiner und weniger aufwendig wären. Das ist gerade für Kleine und Mittlere Unternehmen (KMU) von Bedeutung.

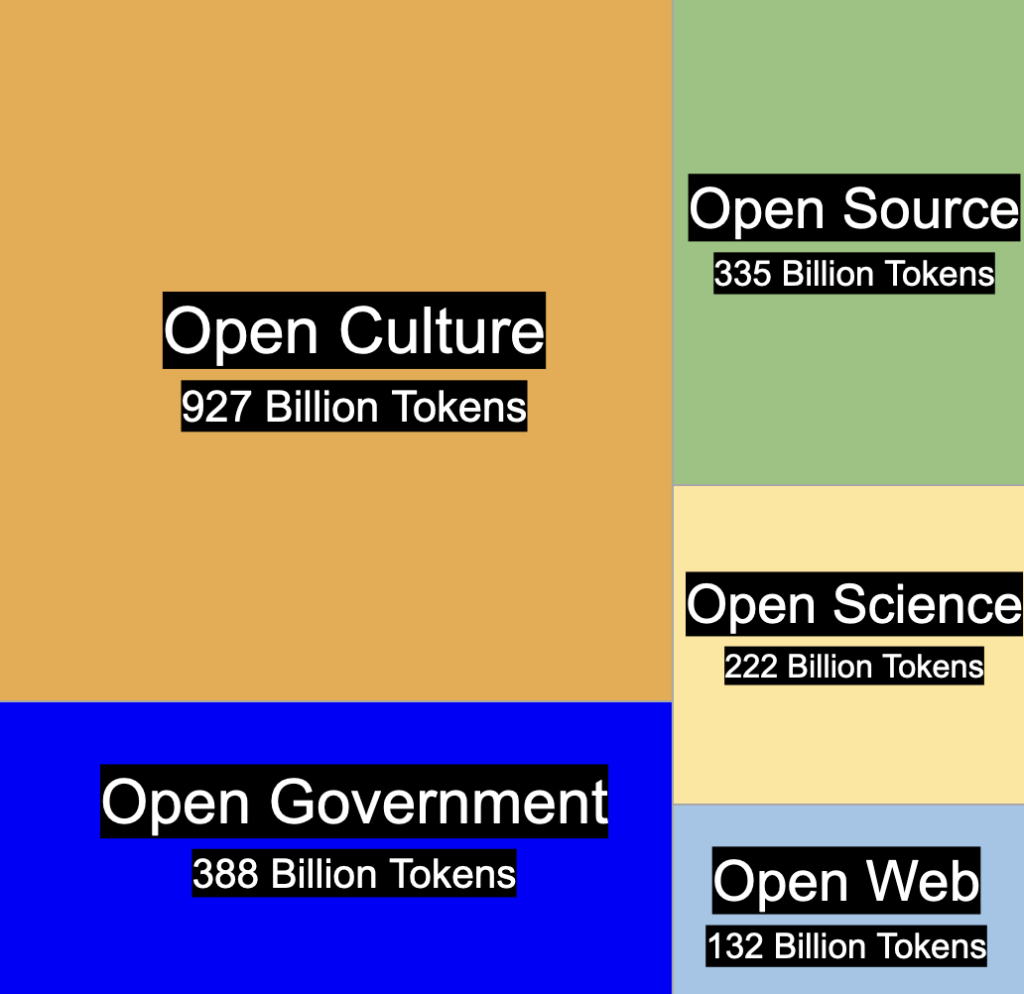

Nicht zuletzt kann auch immer mehr leistungsfähige Open Source AI eingesetzt werden. Dabei beziehe ich mich auf die zuletzt veröffentlichte Definition zu Open Source AI. Eine Erkenntnis daraus ist: OpenAI ist kein Open Source AI. Die zuletzt veröffentlichten Modelle wie TEUKEN 7B oder auch Comon Corpus können hier beispielhaft für “wirkliche” Open source AI genannt werden.

Weiterhin speilen in Zukunft AI Agenten – auch Open Source – eine immer wichtigere Rolle.