Digitale Souveränität wird oftmals mit Daten-Souveränität in Organisationen verwechselt. Es ist daher wichtig zu verstehen, was Organisationale Daten-Souveränität ausmachen kann. Dazu habe ich folgenden Vorschlag in einem Paper gefunden:

„We define organizational data sovereignty as the self-determined and deliberate exercise of control over an organization’s data assets, which includes the recognition of their value, the proactive management of data activities (collection, storage, sharing, analysis, and interpretation), and the ability to assimilate and apply these data to drive value creation through interorganizational collaboration“ (Moschko et al. 2024).

In dem Paper geht es den Autoren um Organisationale Daten-Souveränität in Bezug auf Open Value Creation (OVC) in offenen Innovationsprozessen (Open Innovation).

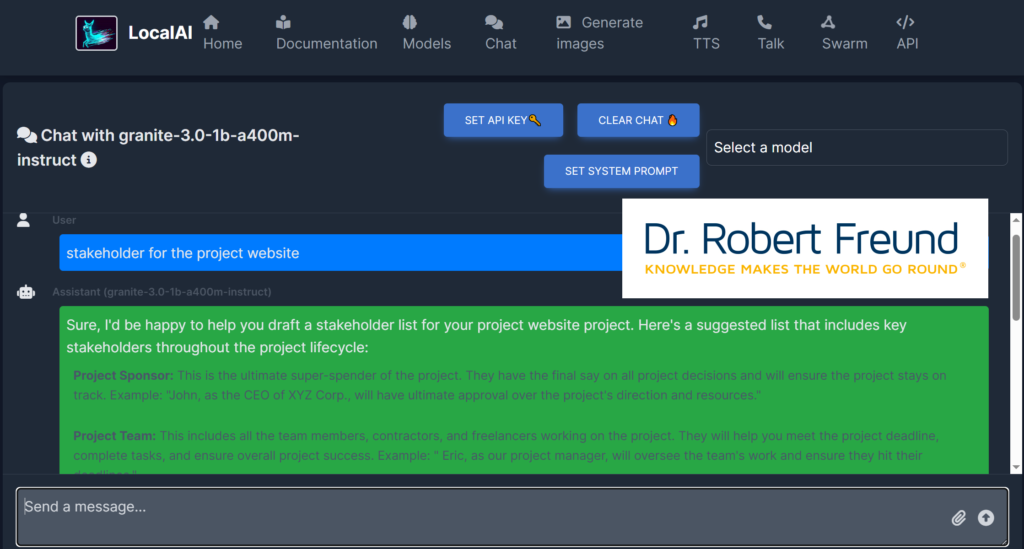

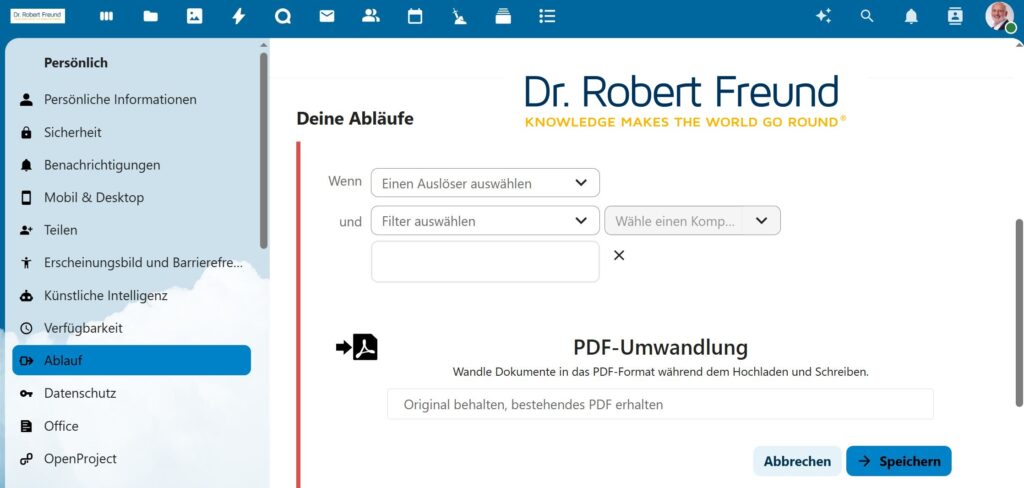

Die hier angesprochene eigene (organisationale) Kontrolle der Daten würde durch den Einsatz von proprietären (Closed Models) KI-Anwendungen konterkariert, da man bei deren Nutzung nicht wirklich weiß, was mit den eigenen Daten passiert. Siehe dazu auch Künstliche Intelligenz: Würden Sie aus diesem Glas trinken?

In dem Blogbeitrag Digitale Souveränität, oder doch nur Souveränitäts-Washing? finden Sie eine Definition von Digitaler Souveränität. Dabei werden Sie feststellen, dass Digitale Souveränität in diesem Sinne nur möglich ist, wenn Open Source AI – Modelle verwendet werden.