Viele kleine und mittlere Unternehmen (KMU) müssen im Gegensatz zu Großunternehmen viel genauer auf ihre Vorhanden Ressourcen achten. Um die Produktivität zu verbessern setzen viele KMU daher auf Kaizen, oder in deutsch: Kontinuierlicher Verbesserungsprozess (KVP). Dabei spielt der Einfallsreichtum der Mitarbeiter eine wichtige Rolle.

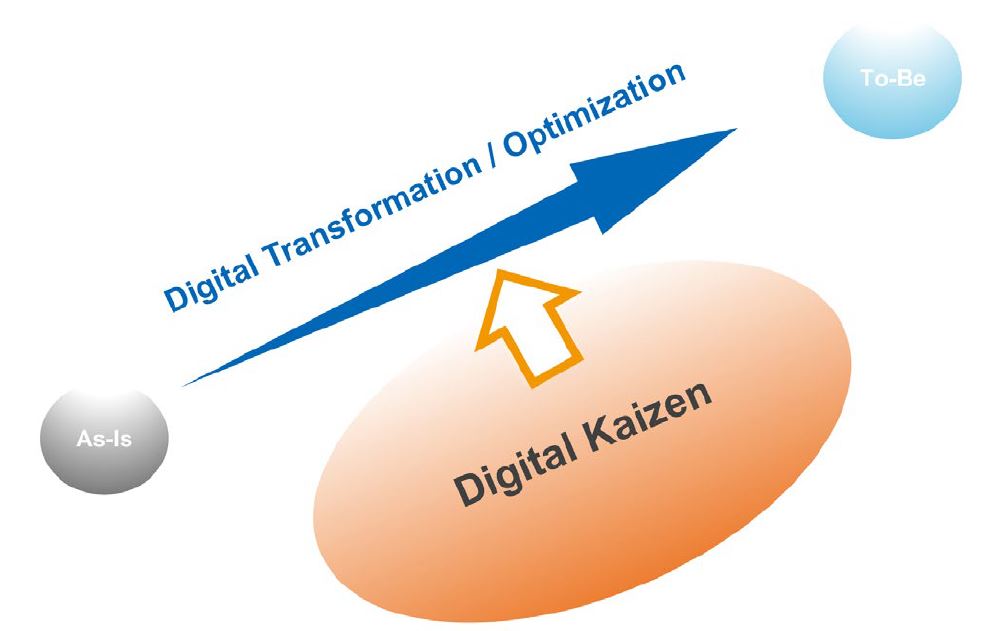

Auch in KMU wird darüber hinaus auch die Digitalisierung immer stärker genutzt, sodass es in Zukunft darauf ankommen wird, ein für das jeweilige Unternehmen abgestimmte Vorgehensweise zu entwickeln. Dabei kommt es auf die Balance zwischen dem Einfallsreichtum der Mitarbeiter, den digitalen Technologien und von Digital Kaizen an.

“Traditionally, kaizen has significantly contributed to improving productivity in small SMEs. This is because one aspect of kaizen is to increase productivity through human ingenuity while reducing investment. As the importance of digital technology is increasingly recognized alongside the advancement of AI, human ingenuity or the kaizen mindset is becoming more and more important, not less. In other words, the Digital Kaizen concept is essential for SMEs that need to curb their investments” (APO 2024).

Siehe dazu auch Digital Transformation: Kein Erfolg ohne Digital Kaizen?

Solche Zusammenhänge thematisieren wir auch in den von uns entwickelten Blended Learning Lehrgängen Projektmanager/in (IHK) und Projektmanager/in Agil (IHK), die wir an verschiedenen Standorten anbieten. Weitere Informationen zu den Lehrgängen und zu Terminen finden Sie auf unserer Lernplattform.