Wie Sie wissen, haben wir auf unserem Server die Möglichkeit eingerichtet, KI-Modelle lokal auszuwählen und zu testen, bzw. zu nutzen – LokalKI oder LocalAI. Siehe dazu Free Open Source Software (FOSS): Eigene LocalAI-Instanz mit ersten drei Modellen eingerichtet.

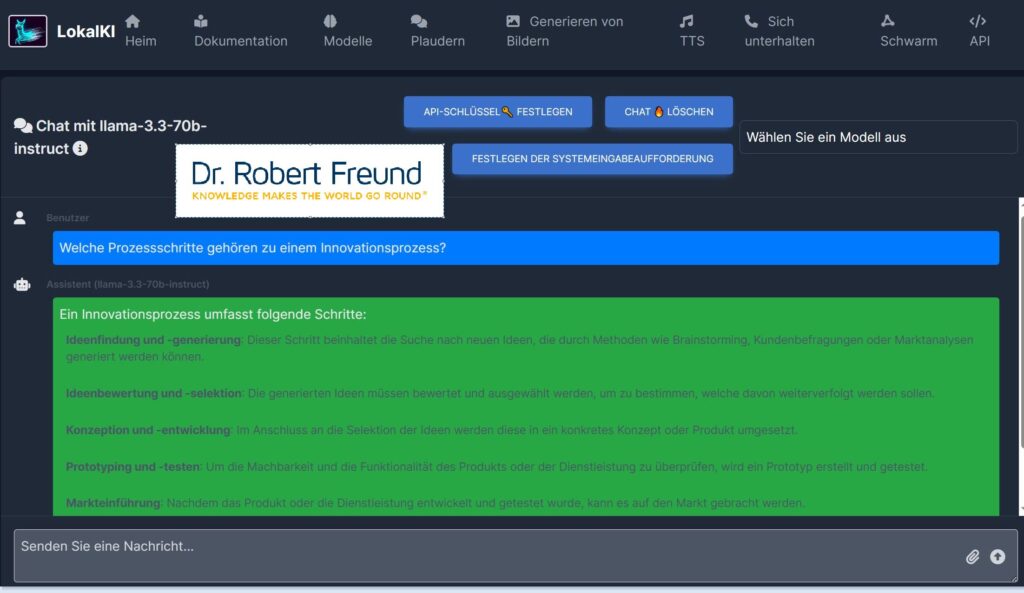

Die verschiedenen Modelle können dazu vorab ausgewählt werden. Für diesen Test habe ich Llama 3.3 70B ausgewählt, was in der Abbildung zu erkennen ist. LLama 3.3 ist ein nur textbasiertes Modell, das den Vorteil hat, deutlich weniger Rechenaufwand zu benötigen, als z.B. LLama 3.1 405B.

Die Eingabetext wird unten in dem dunkelgrau hinterlegten Feld eingetragen und erscheint dann in dem blau hinterlegten Feld.

Eingabe: Welche Prozessschritte gehören zu einem Innovationsprozess?

Das Ergebnis (Grün hinterlegt) kann sich für den ersten kleinen Test sehen lassen. Die Prozessschritte sind genannt und erläutert.

Die Antwortzeit war relativ kurz, was bei der Modellgröße von 70B durchaus überrascht. Immerhin haben wir keine besondere Rechenleistung installiert.

Der Vorteil ist auch hier: Alle Daten der KI-Anwendung bleiben auf unserem Server .