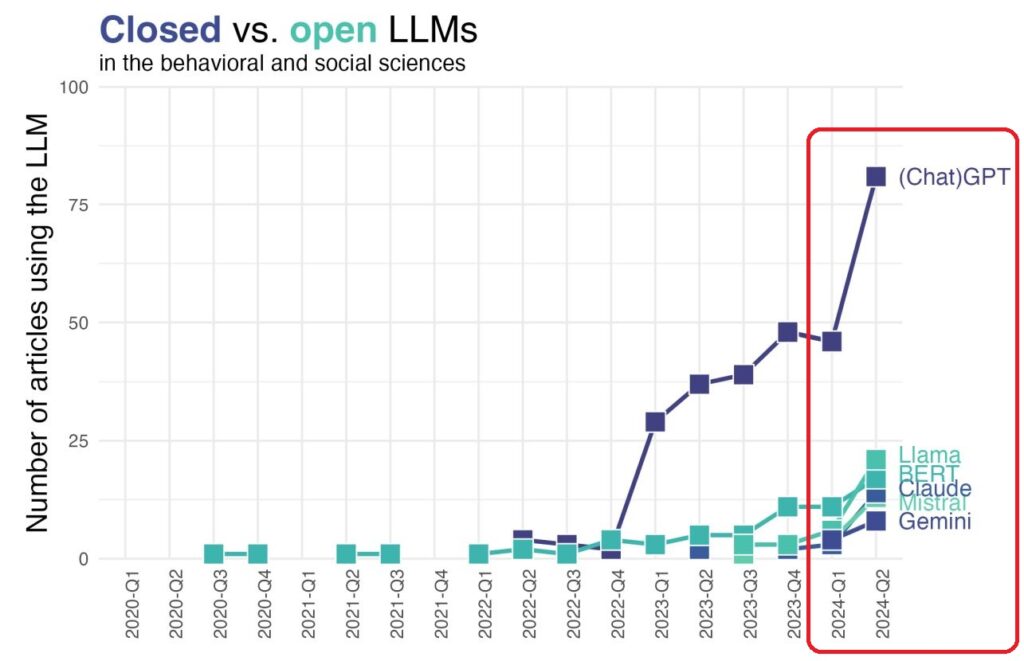

Natürlich verwenden immer mehr Wissenschaftler Künstlichen Intelligenz in ihrer Arbeit. Wie die Grafik zeigt, wird ChatGPT beispielsweise in den Verhaltens- und Sozialwissenschaften sehr stark genutzt. ChatGPT ist allerdings von OpenAI, dessen Large Language Model (LLM) als eher geschlossenes System (Closed LLM) bezeichnet werden kann, da das zugrundeliegende Datenmodell nicht transparent ist. Andere LLM – wie z.B. LLama – sind eher offen LLM (Open LLM), die gerade für Forschung und Wissenschaft geeigneter erscheinen.

In dem aktuellen Paper Wulff/Hussain/Mata (2024): The Behavioral and Social Sciences Need Open LLMs (PDF) argumentieren die Autoren dazu wie folgt:

“Academic research should prefer open LLMs because they offer several practical and ethical advantages that are essential for scientific progress.

First, open models provide the transparency necessary for thorough scrutiny, allowing researchers to understand better the tools they are using and ensuring accountability.

Second, this transparency, combined with the adaptability of open models, facilitates innovation by enabling researchers to customize models to meet specific needs and explore new applications (Wulff & Mata, 2024).

Third, open LLMs support reproducibility, a cornerstone of scientific research, by allowing other researchers to replicate and build upon existing work.

Finally, the ethical implications of AI usage are better managed with open models, as they enable greater scrutiny of AI decisions, arguably reduce the risks of deploying biased or unethical systems, and avoid giving away data to further train closed, proprietary models.”

Ich frage mich an dieser Stelle, ob solche Hinweise nicht auch für die Nutzung von Künstlicher Intelligenz in Unternehmen gelten sollten.

Siehe dazu auch Künstliche Intelligenz: Vorteile von Open-Source-Modellen